In diesem Artikel werden die wichtigsten SEO-Rankingfaktoren aus den Bereichen Content, User Experience, Nutzersignale, Technik und Links vorgestellt. Der Artikel dient als Leitfaden für eine bessere Performance in den SERPs.

Suchmaschinen verwenden Hunderte von Variablen, um die Relevanz einzelner Seiten von Websites zu bewerten. Diese Variablen bilden zusammen die Rankingfaktoren. Sie entscheiden darüber, auf welchen Positionen Websites und deren Inhalte zu bestimmten Keywords in Suchmaschinen platziert werden.

Im SEO-Management dienen Rankingfaktoren als eine Art Wegweiser, wie die Inhalte einer Website für Suchmaschinen optimiert werden sollten. Sie geben eine Orientierung, wie Inhalte technisch und inhaltlich strukturiert sein müssen, damit sie für Suchmaschinen relevant erscheinen.

Abbildung: Veranschaulichung von SEO-Rankingfaktoren. // Quelle: AKDMM

Abbildung: Veranschaulichung von SEO-Rankingfaktoren. // Quelle: AKDMM

Inhalte in diesem Beitrag:

- Rankingfaktoren: Content

- Rankingfaktoren: User Experience

- Rankingfaktoren: Nutzersignale

- Rankingfaktoren: Technik

- Rankingfaktoren: Links

In diesem Beitrag erfahren Sie mehr über die wichtigsten SEO-Rankingfaktoren zu den folgenden Bereichen:

- Content

- User Experience

- Nutzersignale

- Technik

- Links

Abbildung: Veranschaulichung der wichtigsten SEO-Rankingfaktoren als übersichtliche Liste. // Quelle: AKDMM

Abbildung: Veranschaulichung der wichtigsten SEO-Rankingfaktoren als übersichtliche Liste. // Quelle: AKDMM

Rankingfaktoren mit Bezug zum Content

Der Inhalt einer Website ist ein wichtiger Teil der Rankingfaktoren von Suchmaschinen. Ohne Inhalte gäbe es keine Suchmaschinen und ohne Inhalte keine Rankings. Die Suchmaschinen sind auf Inhalte angewiesen, die sie auf Websites vorfinden. Dies können Textinhalte, Videos, Bilder oder auch gesprochene Inhalte sein.

Entscheidend für das Ranking ist die Qualität der Inhalte.

In der Suchmaschinenoptimierung steht die Relevanz der Inhalte im Vordergrund. Um die Relevanz zu beurteilen, nehmen Suchmaschinen bei der Indexierung zunächst eine Bewertung der Content-Qualität vor. Hierbei geht es nicht nur um den reinen Inhalt, sondern auch um Faktoren wie Lesbarkeit, Nutzen und unter anderem auch um Faktoren wie Rechtschreibung und Grammatik. Hieraus entsteht ein Gesamteindruck, welcher in die Bewertung einfließt.

Die Qualität der Inhalte wird insbesondere durch folgende Faktoren beeinflusst:

- Nutzen von Inhalten

- Holistische Inhalte

- Einzigartigkeit von Inhalten

- Lesbarkeit von Inhalten

- Sprachebenen

- Rechtschreibung und Grammatik

Nr. 1: Nutzen von Inhalten

Der Nutzen von Inhalten ist einer der wichtigsten Rankingfaktoren. Er ist maßgeblich dafür verantwortlich, an welcher Stelle eine Website zu einem bestimmten Keyword im Ranking einer Suchmaschine gelistet wird.

Beachten Sie hierbei, dass eine Suchmaschine nach dem „Problem-Lösungs-Prinzip“ funktioniert. Das Problem eines Nutzers wird durch seine Suchanfrage an die Suchmaschine übermittelt. Die Suchmaschine listet daraufhin Suchergebnisse mit relevanten Websites auf, die die bestmögliche Lösung liefern können.

Wenn ein Suchergebnis zu einer Website mit nützlichen Inhalten führt, sind die Nutzer zufrieden. Liefert der Inhalt der besuchten Website keinen nennenswerten Mehrwert, verlassen die Nutzer die Website und folgen dem nächsten Suchergebnis zur nächsten Website.

Nr. 2: Holistische Inhalte

Der inhaltliche Nutzen kann durch die Erstellung von holistischen Inhalten erhöht werden. Das Wort "holistisch" stammt aus dem Griechischen und bedeutet "ganz" oder "ganzheitlich".

Ganzheitliche Betrachtung von Inhalten.

Unter holistischem Content versteht man Inhalte, die ein bestimmtes Thema ganzheitlich und umfassend beleuchten. Sie betrachten ein Thema aus verschiedenen Gesichtspunkten und steigern so den Bezug zu themenrelevanten Inhalten. Holistische Inhalte beantworten nicht nur eine einzelne Frage, sondern eine ganze Reihe an Fragen zu einem Thema.

⇒ In diesem Artikel erfahren Sie mehr über die Vorteile von holistischem Content für SEO.

Die folgenden Merkmale sind für holistische Inhalte charakteristisch:

- Umfassend: Inhalte bieten eine umfassende Sicht auf ein bestimmtes Thema.

- Tiefe Einblicke: Inhalte sind nicht oberflächlich, sondern vermitteln ein tieferes Verständnis.

- Multidisziplinär: Sie beinhalten Perspektiven aus verschiedenen Bereichen, z.B. Informationen aus Wissenschaft, Geschichte oder anderen Themengebieten.

- Gut recherchiert: Die Inhalte sind gut recherchiert, innovativ und bieten eine einzigartige Perspektive auf bestimmte Themen.

- Innovativ: Die Informationen sind innovativ und bieten neue Erkenntnisse.

- Zielgruppenspezifisch: Inhalte sind auf die Zielgruppe zugeschnitten und erfüllen deren Erwartungen und Bedürfnisse.

- Gut lesbar: Inhalte sind trotz einer hohen Komplexität gut lesbar und verständlich geschrieben.

- Multimedial: Inhalte liefern Informationen im besten Fall auch multimedial. Neben Textinhalten werden z.B. auch Bilder, Videos etc. eingesetzt.

Nr. 3: Einzigartigkeit von Inhalten

Als einzigartig können holistische Inhalte dann bezeichnet werden, wenn sie aufgrund ihres umfassenden Blickwinkels und ihrer Informationstiefe Inhalte liefern, die sich von anderen Inhalten unterscheiden.

Als einzigartig können aber nicht nur holistische Inhalte gelten, sondern z.B. auch eine einfache Antwort auf eine simple Frage. Auch eine originelle und kreative Beantwortung einer Frage, z.B. durch hilfreiche Beispiele, kann Einzigartigkeit erzeugen.

Das Rad muss nicht neu erfunden werden.

Einzigartigkeit bedeutet nicht in erster Linie, dass Sie als Betreiber einer Website Inhalte anbieten, die sonst niemand anbietet. Es geht also nicht darum, das Rad neu zu erfinden, sondern darum, Inhalte so aufzubereiten, dass sie einen größeren Nutzen erbringen als andere Inhalte.

Beispiel für die Einzigartigkeit von Inhalten:

Erinnern Sie sich in diesem Beispiel an Ihre Schulzeit zurück und an den Unterricht in Mathematik. Vermutlich gab es ein Thema wie die „Kurvendiskussion“, das Sie seinerzeit nie wirklich verstanden haben.

Einige Jahre später suchen Sie in einer Suchmaschine nach einer Erklärung zu diesem Thema und finden auf einer Website erstmalig Inhalte, die Ihnen das Thema einfach und verständlich erklären. Der Ansatz, mit dem dieses Thema beschrieben wurde, wird in diesem Fall als einzigartig beurteilt, da er neue Ansätze zur Beschreibung eines bereits bekannten Themas beinhaltete.

Nr. 4: Lesbarkeit von Inhalten

Unter Lesbarkeit von Inhalten versteht man die Leichtigkeit, mit der Inhalte von einer Zielgruppe gelesen werden können. Dabei kann es sich beispielsweise um den Text eines Buches, eines Zeitungsartikels oder einer Website handeln. Ist ein Text leicht zu lesen und verständlich, wirkt sich dies positiv auf die Lesbarkeit aus.

Faktoren, die die Lesbarkeit beeinflussen.

Die Lesbarkeit kann durch verschiedene Faktoren verbessert werden. Ein wesentlicher Faktor ist der Gebrauch von einfachen und leicht verständlichen Wörtern. Im Fokus steht dabei die jeweilige Zielgruppe, für die ein Text geschrieben wird.

Darüber hinaus spielen auch strukturelle Merkmale eines Textes eine Rolle. So können die Länge von Sätzen oder die Trennung von Inhalten in einzelne Absätze die Lesbarkeit erhöhen. Wenn Inhalte den Leser überfordern, weil der Text beispielsweise in einem Block ohne Überschriften geschrieben wurde, kann dies zu Frustration führen. Wenn Texte auf einer Website generell schlecht geschrieben und dadurch schwer lesbar sind, wirkt sich das ebenfalls negativ auf das Nutzererlebnis aus. Im ungünstigsten Fall verlassen die Leser die Website.

Nr. 5: Sprachebenen

In einer Sprache wie beispielsweise der deutschen Sprache existieren verschiedene Sprachebenen. Dabei handelt es sich um Varianten einer Sprache, die sich in Grammatik, Stil und Wortschatz voneinander unterscheiden. So wird zum Beispiel die Umgangssprache vor allem im privaten Umfeld oder unter Jugendlichen gesprochen, während bei offiziellen Anlässen oder unter Geschäftspartnern eine eher gehobene Sprache üblich ist.

Beispiele für Sprach- und Stilebenen:

- Umgangssprache

Diese Sprachebene wird im Alltag verwendet, z.B. unter Freunden. Charakteristisch für die Umgangssprache sind verkürzte Wörter oder u.a. ein vereinfachter und lockerer Wortschatz. - Gehobene Sprachebene

Diese Sprachebene wird zum Beispiel bei offiziellen und förmlichen Anlässen verwendet. Die gehobene Umgangssprache folgt grammatikalischen Regeln. Sie zeichnet sich durch eine korrekte Aussprache und einen gehobenen Wortschatz aus. - Fachsprache

Die Fachsprache wird vor allem im beruflichen Umfeld verwendet. Sie zeichnet sich durch die Verwendung von Fachbegriffen aus, die für Laien oft schwer verständlich sind. Auch die Fachsprache folgt den Regeln der Hochsprache.

Nr. 6: Rechtschreibung und Grammatik

Korrekte Rechtschreibung und Grammatik sind Grundvoraussetzungen für die Lesbarkeit von Texten. In der Regel wirkt ein Text auf den Leser unprofessionell, wenn er mit Fehlern übersät ist. Dadurch sinkt die Motivation des Lesers, sich weiter mit dem Inhalt zu beschäftigen.

Einfluss auf die Qualitätsbewertung.

Für Suchmaschinen wie Google oder Bing sind Rechtschreib- und Grammatikfehler leicht zu erkennen. Wenn Crawler eine Website und deren Inhalte analysieren, beziehen sie auch diese Aspekte in die Qualitätsbewertung mit ein. Ist also ein Text relevant, gut lesbar und frei von Fehlern, zeugt dies von hoher Qualität. Wenn ein Text hingegen inhaltlich gut, aber mit Fehlern durchsetzt ist, verschlechtert sich das Qualitätsurteil.

Da auch die Algorithmen der Suchmaschinen die Lesbarkeit und Verständlichkeit der Inhalte bewerten, ist es empfehlenswert, Texte vor der Veröffentlichung auf mögliche Fehler zu überprüfen. Website-Betreiber laufen Gefahr, bei zu vielen Fehlern eine schlechte Bewertung durch Suchmaschinen zu erhalten, was sich letztlich auch auf das Ranking in Suchmaschinen auswirkt.

Fehlerhafte Texte werden weniger geteilt.

In diesem Zusammenhang sollten Sie auch daran denken, dass gute Inhalte von den Nutzern geteilt werden. Rechtschreib- und Grammatikfehler können sich negativ auf das Teilen von Inhalten auswirken. Beurteilen Nutzer die Qualität und Lesbarkeit einer Website positiv, ist es wahrscheinlicher, dass sie die Website als Empfehlung mit anderen Nutzern teilen. Da Links zu einer Website zu den wichtigsten Rankingfaktoren zählen, sollte auf eine hohe Qualität der Beiträge Wert gelegt werden.

Rankingfaktoren in Bezug auf die User Experience

Wenn es um die Inhalte einer Website geht, spielt das Nutzererlebnis eine besondere Rolle. Bieten Inhalte einen Mehrwert und sind sie hilfreich, wirkt sich das positiv auf das Nutzererlebnis aus.

Unter dem im SEO-Bereich gängigen Begriff „User Experience“ (abgekürzt: UX, deutsch: „Nutzererfahrung“ oder „Nutzererlebnis“) werden allerdings noch weitere Faktoren betrachtet, die sich auf die Erfahrung von Nutzern und deren Nutzererlebnis auswirken.

Die User Experience umfasst folgende Bestandteile, die nachfolgend näher beschrieben werden:

- Visuelle Darstellung

- Benutzerfreundlichkeit

- Zugänglichkeit

Nr. 7: Visuelle Darstellung

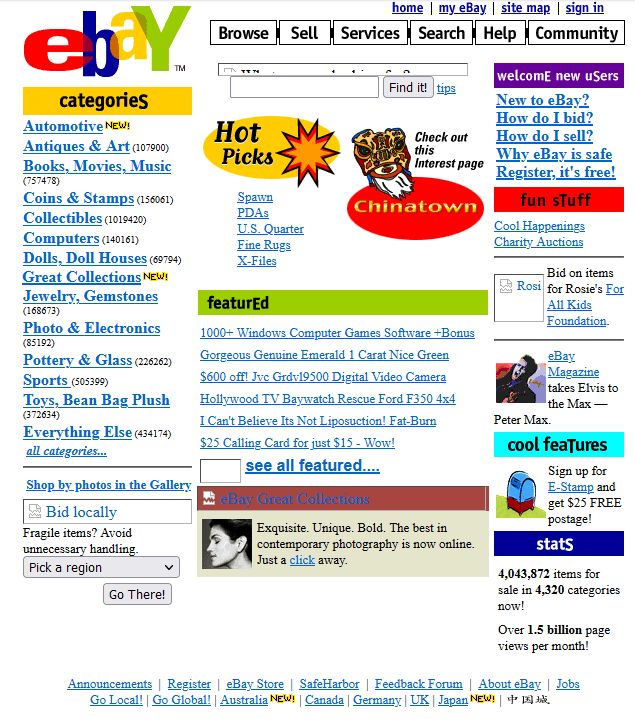

Vielleicht erinnern Sie sich noch daran, wie Websites vor 20 Jahren aussahen. Das Design von Websites war noch sehr verschachtelt und konnte für den Nutzer manchmal überfordernd wirken. Smartphones waren bei weitem noch nicht so verbreitet, wie wir es heute gewohnt sind. Das gilt auch für das Surfen im Internet mit dem Smartphone. Früher war das Webdesign noch rein auf Desktop-Endgeräte und vor allem auf PCs ausgerichtet.

Abbildung: Die Website von Ebay vor über 20 Jahren. // Quelle: Wayback Machine, https://web.archive.org

Abbildung: Die Website von Ebay vor über 20 Jahren. // Quelle: Wayback Machine, https://web.archive.org

Die Optik beeinflusst das Nutzererlebnis.

Die Zeiten haben sich geändert. Heute gibt es viel mehr Gestaltungsmöglichkeiten, um Websites visuell ansprechender zu machen. Die visuelle Gestaltung konzentriert sich dabei in erster Linie auf die Verbesserung der User Experience. Für Suchmaschinen ist das Aussehen einer Website weniger interessant.

Die visuelle Darstellung wird für Suchmaschinen erst dann wichtig, wenn sich beispielsweise Gestaltungselemente störend auf das Crawling einer Website auswirken. Dies wiederum kann Auswirkungen auf die Indexierung der Inhalte und damit auf die Sichtbarkeit in den SERPs (Search Engine Result Pages) haben. Obwohl das Erscheinungsbild einer Website kein Rankingfaktor für Suchmaschinen darstellt, kann es dennoch die User Experience beeinflussen. Schon aus diesem Grund sollte auch den ästhetischen Aspekten einer Website Beachtung geschenkt werden.

Nr. 8: Usability

Die Benutzungsfreundlichkeit (Usability) ist ein wichtiger Aspekt der User Experience. Im Bereich SEO ist der Begriff Usability weit verbreitet. Er fasst zusammen, wie einfach und effektiv Nutzer mit einer Website, einer App oder einem anderen Produkt interagieren können.

Im Zusammenhang mit Websites bezieht sich die Usability darauf, ob die Inhalte von den Nutzern zufriedenstellend abgerufen werden können. Ist eine Website also einfach zu bedienen und erfordert sie nur minimalen Aufwand, um die gewünschten Ziele zu erreichen, spricht dies für eine gute Usability.

Eine schlechte Usability kann zu einer schlechten Bewertung führen.

Finden Nutzer auf einer Website nicht auf Anhieb, wonach sie suchen, kann dies zu Frustration führen. Zahlreiche Nutzer neigen dann dazu, eine Website wieder zu verlassen. Wird durch ein solches Nutzerverhalten die „Return-to-Search“-Rate beeinflusst, wirkt sich dies negativ auf das Suchmaschinenranking aus.

Nr. 9: Zugänglichkeit

Für Suchmaschinen wie Google oder Bing ist es von großer Bedeutung, dass die Nutzer ohne größere Hindernisse auf die Inhalte einer Website zugreifen können. In diesem Zusammenhang bezieht sich die Zugänglichkeit insbesondere auf die verschiedenen Endgeräte, die von den Nutzern beim Besuch einer Website verwendet werden.

55% der weltweiten Online-Besuche erfolgen über mobile Endgeräte.

Ein Blick auf die weltweiten Website-Besuche zeigt, dass Smartphones die einst dominierenden Desktop-Endgeräte wie Laptops oder PCs überholt haben. Der Anteil der Smartphones an den weltweiten Onlinebesuchen wird 2021 bei 55 Prozent liegen. Endgeräte wie PCs oder Laptops wurden dagegen in rund 43 % der Fälle von den Nutzern verwendet. Auf Tablets entfielen lediglich 2%. Quelle: (Kinsta.com, 2021)

Fokus auf responsive Websites.

Der Fokus von Webseitenbetreibern sollte auf der Bereitstellung von „Responsive Websites“ liegen, um insbesondere Smartphone-Nutzern ein gutes Nutzungserlebnis zu bieten. "Responsive" bezeichnet die Fähigkeit einer Website, auf unterschiedliche Endgeräte zu reagieren. Dadurch verändert sich das Erscheinungsbild einer Website und passt sich optisch an die verfügbaren Dimensionen des jeweiligen Endgerätes an.

Rankingfaktoren in Bezug auf Nutzersignale

Bei der Bewertung von Websites sind Nutzersignale für Suchmaschinen ein wichtiger Einflussfaktor. Wenn wir uns im Folgenden auf die Google-Suche konzentrieren, hat sich seit der Einführung von maschinellem Lernen und dem Einsatz von KI (Künstliche Intelligenz) vieles weiterentwickelt.

Maschinelles Lernen zur Erkennung von Nutzersignalen.

Noch vor einigen Jahren waren bei der Entwicklung der Algorithmen der Google-Suchmaschine Ingenieure die treibende Kraft. Die Programmierung des Algorithmus erfolgte hauptsächlich durch menschliche Eingriffe. Erst 2015 bestätigte Google den Einsatz von „Rankbrain“. Hierbei handelt es sich um eine künstliche Intelligenz, die über einen selbstlernenden Algorithmus verfügt. Diese Form des maschinellen Lernens spielt seitdem eine wesentliche Rolle bei der Sortierung der Suchergebnisse in den SERPs der Google-Suche.

Die Absichten der Nutzer werden erkannt und verstanden.

Nutzer, die Suchmaschinen aufsuchen, verfolgen bestimmte Absichten (Intentionen). Wenn die Suchmaschine mit Hilfe von Rankbrain erkennt, dass Nutzer informationsorientiert sind, werden in den Suchergebnissen Websites aufgelistet, die Informationen und Antworten zu einem Thema oder einer Frage liefern. Stellt die Suchmaschine fest, dass der Nutzer bereit ist, etwas zu kaufen, listet sie aufgrund der transaktionsorientierten Intention Suchergebnisse auf, die zu einem Kauf führen können.

Rankbrain reagiert auf Nutzersignale.

Nutzersignale sind für die Sortierung der Suchergebnisse von großer Bedeutung. Künstliche Intelligenz reagiert auf Nutzersignale und passt den Algorithmus entsprechend an.

Die folgenden wichtigen Nutzersignale werden von Suchmaschinen zur Bewertung herangezogen:

- Absprungrate

- Return-to-Search

- Verweildauer

- CTR (Klickrate)

Nr. 10: Absprungrate

Die Absprungrate (engl.: „Bounce Rate“) gilt als wichtige Kennzahl zur Beurteilung der Performance einer Website und einzelner Unterseiten. Sie gibt an, wie viele Besucher eine Seite ohne Interaktion wieder verlassen. Das Verlassen einer Seite ohne Interaktion wird im Online-Marketing als „Bounce“ bezeichnet. Für die Berechnung der Absprungrate wird die Gesamtzahl aller Besucher ins Verhältnis zu den Absprüngen gesetzt.

Die Formel für die Absprungrate lautet wie folgt:

Besucher mit einem Seitenaufruf / Gesamtzahl der Besucher x 100 = Absprungrate

Bedeutung der Absprungrate aus Sicht der Websitebetreiber.

Eine Nutzerin verfolgt eine informationsorientierte Suchabsicht. Sie will wissen, wann in einem bestimmten Monat Vollmond ist. Über eine Suchmaschine gelangt sie auf eine Website, die ihr direkt und gut sichtbar ein konkretes Datum für den nächsten Vollmond nennt.

Die Nutzerin erhält eine zufriedenstellende Antwort und verlässt die Website ohne weitere Interaktion. In diesem Fall wird sie im Analysetool als Bounce gekennzeichnet. Ein solcher Bounce deutet jedoch auf ein normales Nutzerverhalten hin und kann daher nicht als schlechtes Signal gewertet werden.

Gründe für eine hohe Absprungrate.

Eine hohe Absprungrate ist nicht zwangsläufig ein Hinweis auf fehlerhafte Inhalte. Bei der Analyse hoher Absprungraten sollten Website-Betreiber auch andere Gründe in Betracht ziehen. Neben inhaltlichen Faktoren sollten bei der Analyse hoher Absprungraten auch gestalterische oder technische Aspekte überprüft werden. So können sich zu lange Ladezeiten einer Website oder zu viel Werbung negativ auf die Absprungrate auswirken.

Gleiches gilt für Aspekte der visuellen Darstellung, die sich störend auf das Nutzererlebnis auswirken können. So kann beispielsweise eine ungünstige Wahl der verwendeten Schriftart dazu führen, dass Inhalte auf Smartphones nur schwer lesbar sind.

Nr. 11: Return-to-Search

„Return-to-Search“ wird als „Rückkehr zur Suche“ übersetzt. Die Kennzahl wird auch als „Return-to-SERP“ bezeichnet. Sie gilt für Suchmaschinen als Indikator dafür, ob Nutzer mit einem Suchergebnis und dem Inhalt der verlinkten Website zufrieden waren.

Abbildung: Veranschaulichung von "Return to Search". // Quelle: AKDMM

Abbildung: Veranschaulichung von "Return to Search". // Quelle: AKDMM

Wenn Nutzer in einer Suchmaschine auf ein Suchergebnis klicken, werden sie auf eine bestimmte Website weitergeleitet. Kehren die Nutzer nach dem Besuch der Website zur Suchmaschine zurück, um ihre Suche fortzusetzen, spricht man von „Return-to-Search“. Ein solches Nutzerverhalten ist für Suchmaschinen ein Indikator dafür, dass Nutzer auf einer besuchten Website keine geeigneten Inhalte zur Lösung eines „Problems“ gefunden haben.

Die Messung der Return-to-Search-Rate ist nur indirekt möglich.

Die Return-to-Search Rate ist für Webseitenbetreiber nicht direkt messbar. Es handelt sich um eine Kennzahl, die von Suchmaschinen verwendet wird. Ein Einblick in die Return-to-Search-Rate ist für Websitebetreiber nur indirekt möglich. So kann beispielsweise die Analyse der Absprungrate (Bounce Rate) Aufschluss geben. Ist die Absprungrate zu hoch, kann dies darauf hindeuten, dass Nutzer mit einem Artikel unzufrieden waren. Ob die Nutzer anschließend in der Suchmaschine weiter recherchiert haben, ist für den Websitebetreiber nicht ersichtlich.

Nr. 12: Verweildauer

Die Verweildauer gibt die durchschnittliche Verweildauer der Besucher auf einer Website an. Sie gibt an, wie lange sich die Nutzer vom Betreten bis zum Verlassen einer Website auf dieser aufhalten. Im Englischen wird die Verweildauer auch als "Average Time on Site" bezeichnet. Neben der Absprungrate zählt die Verweildauer zu den wichtigsten KPIs für Website-Betreiber.

Indikator für die inhaltliche Qualität einer Website.

Wenn Nutzer eine Website besuchen und nach kurzer Zeit wieder abspringen, kann dies ein Indikator für mangelhafte oder irrelevante Inhalte sein. Wenn eine Seite etwas komplexere Inhalte beinhaltet und die durchschnittliche Verweildauer der Besucher unerwartet niedrig ist, kann dies ein Indikator für eine schlechte Qualität der Inhalte sein. Ist die Verweildauer hingegen hoch, kann dies auf ein erhöhtes Interesse der Besucher an der Seite hindeuten. Im letzteren Fall wäre eine lange Verweildauer ein Indikator für qualitativ hochwertige Inhalte.

Verweildauer als Rankingfaktor.

Je nach Art der Suchanfrage von Nutzern kann die Verweildauer als Rankingfaktor in Suchmaschinen an Bedeutung gewinnen oder verlieren. Handelt es sich beispielsweise um Suchanfragen, bei denen die Nutzer eine kurze Antwort erwarten, wird die Verweildauer vermutlich eine geringere Rolle bei der Bewertung einer Website spielen.

In welchem Umfang die Verweildauer als Rankingfaktor herangezogen wird, bleibt, wie bei vielen anderen Rankingfaktoren auch, reine Vermutung. Dennoch sollten Kennzahlen wie Verweildauer und Absprungrate bei der Optimierung für Suchmaschinen berücksichtigt werden.

Nr. 13: CTR

CTR ist die Abkürzung für den englischen Begriff „Click-Through-Rate“ und bedeutet übersetzt „Klickrate“. Die Klickrate beschreibt das Verhältnis zwischen "Klicks" und "Impressionen" und wird üblicherweise in Prozent angegeben.

Die Formel für die CTR lautet wie folgt:

Klicks / Impressionen x 100 = CTR

Bedeutung der CTR für die Suchmaschinenoptimierung.

Allgemein gilt eine hohe CTR als positives Signal. Sie ist ein Hinweis darauf, dass ein Suchergebnis für die Nutzer relevant und attraktiv ist. Ist die CTR niedrig, kann dies darauf hindeuten, dass ein Suchergebnis für den Nutzer nicht relevant genug erscheint. Sie kann aber auch ein Zeichen dafür sein, dass ein Suchergebnis in den SERPs nicht gut platziert ist.

Die ersten Suchergebnisse einer Suchanfrage erhalten in der Regel die meisten Impressionen und Klicks. Bereits die Position in den SERPs kann über die Höhe der CTR entscheiden. Mit anderen Worten: Das letzte Suchergebnis einer SERP hat immer einen niedrigeren CTR-Wert als das erste Suchergebnis.

Die Klickrate als Rankingfaktor.

Die CTR dient Suchmaschinen als Nutzersignal. Als wichtiger KPI (Key Performance Indicator) signalisiert sie Suchmaschinen, dass Nutzer ein bestimmtes Suchergebnis gegenüber anderen Suchergebnissen bevorzugen. Stellt eine Suchmaschine fest, dass bestimmte Suchergebnisse eine bessere Klickleistung aufweisen als andere, kann das zu einer verbesserten Platzierung führen. Dies gilt unter der Voraussetzung, dass auch andere Faktoren, die nach dem Klick zum Tragen kommen, positive Signale aussenden.

Rankingfaktoren bezogen auf die Technik

Bei der Suchmaschinenoptimierung bilden die technischen Rankingfaktoren einen der wichtigsten Faktoren. Nur wenn bestimmte technische Voraussetzungen erfüllt sind, können Websites und deren Inhalte von Suchmaschinen gefunden bzw. leichter analysiert werden.

Die folgenden technischen Rankingfaktoren gehören zu den wichtigsten Faktoren im Bereich SEO:

- Sitemap

- robots.txt

- Quellcode

- Ladezeiten

- Sichere Datenübertragung

Nr. 14: Sitemap

Bei einer Sitemap handelt es sich um eine Art Inhaltsverzeichnis für Websites. Sie ist hierarchisch aufgebaut und zeigt, wie die Seitenstruktur einer Website aufgebaut ist. Auf diese Weise werden die Zusammenhänge zwischen den einzelnen Seiten einer Website für Suchmaschinen sichtbar.

Mit einer Sitemap können Suchmaschinen-Crawler die Seiten und Inhalte einer Website effizienter durchsuchen. Insbesondere bei größeren Websites mit vielen Inhalten und Kategorien wird die Bereitstellung einer Sitemap zunehmend wichtiger. Bei kleineren Websites können Crawler auch ohne Sitemap auskommen, sofern die Inhalte der Website eindeutig verlinkt sind.

Nr. 15: Robots.txt

Crawler oder Bots, die eine Website besuchen, rufen zunächst die Datei „robots.txt“ auf. Dabei handelt es sich um eine Textdatei, die Handlungsanweisungen für Suchmaschinen beinhaltet. In einer robots.txt wird den Crawlern mitgeteilt, auf welche Verzeichnisse einer Website sie zugreifen dürfen und welche Verzeichnisse sie nicht durchsuchen sollen.

Die robots.txt hat keinen direkten Einfluss auf das Ranking einer Website. Da sie jedoch den Crawlern den Weg durch die Website erleichtert, hat sie einen positiven Einfluss auf den Crawling-Prozess. Dies wiederum beeinflusst die Wahrscheinlichkeit, dass möglichst viele Seiten einer Website gecrawlt werden.

Platzierung der robots.txt im Root-Verzeichnis.

Damit Suchmaschinen die Datei robots.txt finden, sollte sie im Root-Verzeichnis hinterlegt werden. Ist dies nicht der Fall, besteht die Gefahr, dass sie von Suchmaschinen nicht gefunden wird. Die Befehle in der robots.txt werden dann von den Crawlern ignoriert.

Es gibt keine Garantie dafür, dass Suchmaschinen die Anweisungen und Befehle der robots.txt immer befolgen. In Einzelfällen kann es vorkommen, dass Suchmaschinen die Anweisungen schlicht ignorieren. Dennoch wird die robots.txt im Allgemeinen als nützliches Orientierungsinstrument für Crawler angesehen, weshalb ihre Verwendung sehr zu empfehlen ist.

Nr. 16: Quellcode

Der Quellcode (auch "Source Code" oder "Quelltext" genannt) ist eine Sammlung von Anweisungen oder Befehlen, die in einer Programmiersprache geschrieben sind. Der Quellcode wird von Entwicklern erstellt, um z. B. ein Computerprogramm oder eine Website zu entwickeln. Er kann aus verschiedenen Skriptsprachen bestehen, die zusammen das Aussehen, die Struktur und die Funktionalität der Website bestimmen.

Der Quellcode und seine Bedeutung für SEO.

Fehlerfreier Code einer Website ist eine der Grundvoraussetzungen für die Suchmaschinenoptimierung. Durch Programmierfehler kann die User Experience beeinträchtigt werden. Außerdem können Programmierfehler zu Einschränkungen im Crawling-Prozess der Suchmaschinen führen. Ein wichtiger Bestandteil der technischen Suchmaschinenoptimierung ist daher die Optimierung des Quellcodes einer Website. Ein sauberer Quellcode ist wichtig, da dieser von den Crawlern der Suchmaschinen verwendet wird, um den Inhalt und die Struktur einer Website zu analysieren und somit eine Bewertung vorzunehmen.

Suchmaschinen-Crawler „lesen“ die Inhalte einer Website durch Analyse des Quellcodes.

Wenn der Quellcode für die Crawler ohne Hindernisse lesbar ist, kann dies die Crawling-Geschwindigkeit und damit die Anzahl der analysierten Seiten erhöhen. Wird der Code zudem so optimiert, dass die Ladegeschwindigkeit der Website verbessert wird, wirkt sich dies positiv auf das Ranking aus.

Die folgenden Code-Elemente sind für die Suchmaschinenoptimierung besonders relevant:

- HTML-Tags

- Meta-Tags

- ALT-Tags

- Strukturierte Daten

- Duplicate Content

Nr. 17: HTML-Tags

Die Abkürzung HTML steht für "Hypertext Markup Language". Es handelt sich um eine Auszeichnungssprache, die zur Erstellung und Formatierung von Webseiten verwendet wird. Sie beschreibt die Struktur und den Inhalt von Webseiten. HTML definiert Elemente und Attribute, die zur Erstellung von Texten, Bildern, Videos, Links und anderen Medien verwendet werden.

Browser verwenden den HTML-Code und wandeln ihn um. Auf diese Weise entsteht aus reinem Textcode eine Website mit Bildern, Strukturen, Farben usw., wie wir sie als Nutzer beim Surfen gewohnt sind.

Nr. 18: Meta-Tags

Meta-Tags sind Bestandteile der sogenannten Metadaten. Sie sind Teil der HTML-Tags, werden aber zum besseren Verständnis und zur Differenzierung als Meta-Tags bezeichnet. Die Meta-Tags geben Auskunft über die Daten und Informationen eines HTML-Dokuments.

Mit den Metadaten und den verwendeten Meta-Tags erhalten Suchmaschinen z.B. Informationen darüber, worum es auf einer Seite geht, wer der Autor eines Textes ist und u.a. auch, ob eine Indizierung der Seite in Suchmaschinen erwünscht ist.

Im Folgenden werden die wichtigsten bzw. bekanntesten Meta-Tags vorgestellt:

- Titel-Tag

- Meta-Description

- Keyword-Tag

- Robots-Tag

- ALT-Tag

Nr. 19: Title-Tag

Der „Title“ bezeichnet den Seitentitel einer einzelnen Seite innerhalb einer Website. Er wird innerhalb des Quelltextes im Kopfbereich <head> als <title> gekennzeichnet. Der "Title" wird oft als "Title-Tag" bezeichnet. Diese Bezeichnung hat sich im Laufe der Zeit weitgehend durchgesetzt.

Allerdings ist der Title kein Tag, sondern ein Bestandteil des HTML-Codes. Genauer gesagt handelt es sich um eine obligatorische Angabe in HTML-Dokumenten. Der Einfachheit halber wird der "Title" nachstehend als "Title-Tag" bezeichnet, um eine Abgrenzung zum HTML-Code zu schaffen und Verwechslungen zu vermeiden.

Weitere gebräuchliche Bezeichnungen für den Title sind „SEO-Titel“, „Meta-Titel“ oder einfach „Seitentitel“.

Verwendung des Title-Tags in den Suchergebnissen.

In der Regel wird der Inhalt des Title-Tags von Suchmaschinen als Titel für das entsprechende Suchergebnis verwendet. Die Aussagekraft des Seitentitels kann die Klickwahrscheinlichkeit von Nutzern beeinflussen. Daher sollte der Titel möglichst das Interesse der Nutzer wecken und den Inhalt der Seite gut zusammenfassen.

Je relevanter und interessanter der Titel eines Suchergebnisses ist, desto höher ist die Wahrscheinlichkeit, dass der Nutzer darauf klickt.

Eines der wichtigsten Elemente der Suchmaschinenoptimierung.

Title Tags zählen zu den wichtigsten Elementen der Suchmaschinenoptimierung. Sie werden als Titel der Suchergebnisse in den SERPs, als Seitentitel im Browser und teilweise auch als Titel in sozialen Netzwerken verwendet. Durch die Optimierung der Title Tags kann die CTR (Click-Through-Rate) der Suchergebnisse erhöht werden.

Eine höhere Click-Through-Rate kann wiederum zu mehr Besuchern führen. Und je mehr Besucher von Suchmaschinen mit niedriger CTR kommen, desto besser kann sich das auf das Ranking auswirken. Vorausgesetzt, andere KPIs (Key Performance Indicators), wie z.B. die Absprungrate, weisen ebenfalls eine gute Performance auf.

Nr. 20: Meta-Description

Die Meta-Description („Description“ = deutsch: „Beschreibung“) ist die Beschreibung des Inhalts einer Seite. Diese wird im Kopfbereich <head> einer Seite innerhalb des Quelltextes angezeigt.

Verwendung der Meta-Description in den Suchergebnissen.

In einigen Fällen wird die Meta-Description von Suchmaschinen als Beschreibungstext für die Suchergebnisse verwendet. Die Google-Suchmaschine verwendet die eingestellte Meta-Description nur dann, wenn sie diese als relevant erachtet.

Bei Google werden die so genannten Snippets als Beschreibung oder Zusammenfassung eines Suchergebnisses in der Google-Suche bezeichnet. Sie stammen aus der Meta-Description bzw. werden von Google bevorzugt und automatisch aus dem Inhalt einer Seite generiert. Je nachdem, welche Quelle aus Sicht von Google relevanter ist, wird die entsprechende Quelle für ein Snippet verwendet.

Meta-Descriptions als Rankingfaktor.

Die Meta-Description hat wie auch das Keyword-Tag ihre Relevanz als Rankingfaktor verloren. Durch jahrelanges Keyword-Stuffing von SEOs wurde die Meta-Description im Jahr 2009 von der Suchmaschine Google nicht mehr als Rankingfaktor berücksichtigt. Die Optimierung der Meta-Description hilft Ihnen also nicht, bessere Positionen in den SERPs zu erreichen. Sie hilft Ihnen aber, potenzielle Besucher oder Kunden auf die Inhalte Ihrer Website aufmerksam zu machen und Interesse zu wecken. Quelle: (Searchmetrics.com, 2022)

Nr. 21: Keyword-Tag

Wie andere Meta-Tags wird auch das Keyword-Tag im <head>-Bereich einer Website platziert. Sein Zweck besteht darin, Beiträge mit bestimmten Keywords zu kennzeichnen. In der Vergangenheit war das Keyword-Tag ein wichtiger Bestandteil der Suchmaschinenoptimierung. Mit der Zeit hat sich dies geändert. Seit 2009 wird das Keyword-Tag von Google nicht mehr als Ranking-Faktor berücksichtigt. Dennoch sollte man das Keyword-Tag zumindest kennen, da es für einige Suchmaschinen noch von Bedeutung sein kann.

Nr. 22: Robots-Tag

In einer robots.txt-Datei werden Anweisungen für Suchmaschinen hinterlegt, wie sie sich auf einer Website verhalten sollen. Mit dem Robots-Tag hingegen legen Sie die Regeln fest, die für den Inhalt einer Website oder einzelner Seiten gelten sollen. Mit dem Robots-Tag wird den Crawlern oder Bots zum Beispiel mitgeteilt, ob bestimmte Seiten indexiert werden sollen oder nicht. Ob sich Suchmaschinen tatsächlich immer an diese Regeln halten, ist jedoch nicht geregelt.

Beispiele für Anweisungen an Suchmaschinen im Robots-Tag:

- index: Gibt an, ob Inhalte indexiert werden sollen.

- noindex: Gibt an, dass Inhalte nicht berücksichtigt und indexiert werden sollen.

- follow: Gibt an, dass Links auf Seiten gefolgt werden soll, damit auch weitere Inhalte anderer Seiten gefunden werden können.

- nofollow: Gibt an, dass den Links nicht gefolgt werden soll.

Nr. 23: ALT-Tags

Das ALT-Tag, auch ALT-Attribut genannt, dient dazu, Bilder mit alternativen Beschreibungen in Textform zu versehen, um sie für Suchmaschinen „lesbar“ zu machen. Die Abkürzung ALT leitet sich von dem Begriff „alternativ“ ab. Als Alternative zum visuellen Bildinhalt wird mit dem ALT-Tag also eine Beschreibung des Bildes in Textform hinterlegt.

Wichtiger Bestandteil der Suchmaschinen-Optimierung.

Bei der Suche nach einem bestimmten Begriff in einer Suchmaschine werden in einigen Fällen neben den Suchergebnissen in Textform auch Suchergebnisse in Form von Bildern angezeigt. Mit dem ALT-Tag wird der Weg der Bilder einer Website in die Bildsuche der Suchmaschinen vereinfacht. Anhand der Beschreibung eines Bildes können Suchmaschinen zuordnen, ob und wann ein Bild als Suchergebnis erscheinen soll und für welche Keywords es relevant ist.

Obwohl Suchmaschinen Bilder und ihre dargestellten Inhalte immer besser analysieren und „lesen“ können, spielt die alternative Beschreibung eines Bildes in Textform für das Crawling immer noch eine wichtige Rolle.

Nr. 24: Structured Data

Bei „Structured Data“ (deutsch: „Strukturierte Daten“) handelt es sich um Daten innerhalb einer Website, die gesondert strukturiert und gekennzeichnet sind. Strukturierte Daten werden verwendet, um Suchmaschinen zusätzliche Informationen über den Inhalt einer Seite zu geben. Dies ermöglicht eine Klassifizierung der Inhalte. Dadurch können Suchmaschinen den Inhalt einer Seite besser verstehen und zuordnen.

Als Structured Data werden Daten innerhalb einer Website bezeichnet, die gesondert strukturiert und gekennzeichnet sind. Sie dienen dazu, Suchmaschinen zusätzliche Informationen über den Inhalt einer Seite zu geben. Hierdurch wird eine Klassifizierung der Inhalte ermöglicht. Auf diese Weise können Suchmaschinen den Inhalt einer Seite besser verstehen und zuordnen.

Strukturierte Daten für die Suchmaschinenoptimierung.

Strukturierte Daten auf einer Website sind kein Garant für eine Verbesserung der Keyword-Positionen in den SERPs. Sie helfen jedoch Suchmaschinen wie Google, Inhalte besser zu verstehen, zu klassifizieren und für Suchanfragen gezielter zu vergeben. Durch die Verwendung von Structured Data werden Rich Snippet-Suchergebnisse möglich. Diese Suchergebnisse sind auffälliger als normale Suchergebnisse.

Abbildung: Veranschaulichung von Rich-Snippets. // Quelle: AKDMM

Nr. 25: Duplicate Content

Duplicate Content (deutsch: „doppelter Inhalt“ oder „doppelte Inhalte“) ist identischer Inhalt, der auf einer Website über verschiedene URLs erreichbar ist. Wenn also identische Inhalte auf mehreren Seiten mit unterschiedlichen URLs innerhalb einer Website abrufbar sind, handelt es sich um Duplicate Content.

Auch ähnliche Inhalte können zu Duplicate Content führen.

Außer identischen Inhalten werden auch solche Inhalte als Duplicate Content bezeichnet, die einander sehr ähnlich sind. Das ist beispielsweise der Fall, wenn einzelne Textblöcke auf verschiedenen URLs nur geringfügig verändert werden. Schnell kann dies z.B. in Online-Shops passieren, wenn von einem Produkt mehrere Varianten angeboten werden.

Entstehung von Duplicate Content.

Es gibt verschiedene Wege, wie Duplicate Content auf einer Website entstehen kann und meist steckt keine böswillige Absicht der Website-Betreiber dahinter. Häufig entsteht Duplicate Content durch Automatismen von Content Management Systemen (CMS) bei der Generierung von URLs für neue Beiträge.

Duplicate Content und sein Einfluss auf das Ranking.

Üblicherweise analysieren Suchmaschinen-Crawler die Seiten einer Website und geben ihre Analysen und Bewertungen ohne große Umwege an den Index weiter. Stoßen die Crawler jedoch auf eine Website mit Duplicate Content, kann dies den Indexierungsprozess behindern. Die Frage, die sich den Crawlern dann stellt, ist, welche der gefundenen identischen Inhalte für die Indexierung und das Suchmaschinenranking berücksichtigt werden sollen. Die Entscheidung, welche der identischen Seiten als Suchergebnis die höchste Priorität und Relevanz erhält, ist dabei nicht immer eindeutig. Umgekehrt würde sich bei einer nur einmal existierenden Seite die Frage der Relevanz nicht stellen.

Wenn Duplicate Content auf einer Website zu häufig vorkommt, kann sich dies negativ auf das Ranking in Suchmaschinen auswirken. Aufgrund der Tatsache, dass Suchmaschinen die Frage nach der Relevanz nicht eindeutig beantworten können, kann es dazu kommen, dass Seiten im Ranking schlechter oder gar nicht angezeigt werden.

Nr. 26: Ladezeiten

Die Ladezeiten von Websites gehören ebenfalls zu den technischen Rankingfaktoren. Besonders dieser Aspekt hat sich zu einem der wichtigsten Kriterien für die Bewertung von Websites entwickelt. Websites, bei denen es mehrere Sekunden dauert, bis die Inhalte vollständig geladen und angezeigt werden, riskieren, dass Nutzer abspringen. Eine zu lange Ladezeit kann das Nutzererlebnis beeinträchtigen und somit die Absprungrate erhöhen.

Suchmaschinen bewerten die Ladegeschwindigkeit.

Die Aufgabe von Suchmaschinen ist es, die für den Nutzer besten Suchergebnisse für die jeweilige Suchanfrage herauszufiltern. Erkennt eine Suchmaschine, dass eine Website zu lange braucht, um ihren Inhalt vollständig zu laden, kann dies bereits ein Grund für ein schlechtes Ranking sein. Eine Website, die aufgrund zu langer Ladezeiten von den Nutzern ohne weitere Interaktion verlassen wird, weist eine höhere Return-to-Search-Rate auf. In diesem Fall suchen die Nutzer in den SERPs nach dem nächstbesten Suchergebnis und setzen ihre Suche fort.

Eine langsame Ladezeit wirkt sich negativ auf den gesamten Crawling-Prozess aus.

Bei langen Ladezeiten geraten die Crawler der Suchmaschinen, die die Inhalte der Websites durchsuchen, auf Hindernisse. Eine zu langsame Ladezeit einer Website wirkt sich negativ auf den gesamten Crawling-Prozess aus. Vor diesem Hintergrund ist es wichtig zu wissen, dass Crawler für einzelne Websites nur ein bestimmtes „Crawling-Budget“ zur Verfügung haben. Mit Crawling-Budget ist die Zeit gemeint, die den Crawlern zur Verfügung steht, um Websites und deren Inhalte zu analysieren.

Reduzierung der Crawling-Tiefe.

Die zur Verfügung stehende Crawling-Zeit ist durch das Crawling-Budget begrenzt. Dies hat entsprechende Auswirkungen auf die „Crawling-Tiefe“. Die Crawling-Tiefe ist die Anzahl der durchsuchten Seiten, die während des Crawling-Prozesses einer Website analysiert werden. Sinkt die Crawling-Tiefe, werden weniger Seiten analysiert. Unterseiten einer Website, die sich tiefer in der Struktur der Website befinden, werden möglicherweise nicht mehr berücksichtigt.

Nr. 27: Sichere Datenübertragung

Die abgesicherte Datenübertragung zwischen Client (Browser) und Server ist für die Suchmaschinenoptimierung von großer Bedeutung. Die weltweit meistgenutzte Suchmaschine Google hat im August 2014 die sichere Datenübertragung mittels HTTPS zu einem Rankingfaktor gemacht.

Was bedeutet HTTPS?

Bei HTTPS handelt es sich um eine Erweiterung von HTTP (Hypertext Transfer Protocol). HTTPS steht für „Hypertext Transfer Protocol Secure“. Der Unterschied zwischen HTTP und HTTPS liegt an der verschlüsselten Datenverbindung mittels SSL- bzw. TLS-Verschlüsselung.

Websites ohne HTTPS-Verbindung werden gesondert gekennzeichnet.

Diejenigen Websites, die nicht über eine sichere Datenverbindung verfügen, sind gegenüber den Websites mit Datenverschlüsselung im Nachteil. Jedenfalls wenn man dies aus der Sicht von Rankingfaktoren betrachtet. Außerdem werden Websites von vielen Browsern, z.B. Google Chrome, als „nicht sicher“ gekennzeichnet, wenn kein gültiges SSL-Zertifikat vorliegt.

Rankingfaktoren in Bezug auf Links

Links stellen einen der wichtigsten Rankingfaktoren bei der Suchmaschinenoptimierung dar. Für Suchmaschinen sind Links eine wertvolle Ressource, um Websites, Themen und Inhalte im Internet zu finden. Daher sind die Crawler der Suchmaschinen ständig auf der Suche nach neuen Inhalten, Links und Websites.

Links können das Ranking einer Website positiv beeinflussen.

Das Ranking einer Website kann sich verbessern, wenn sie von anderen Websites als Referenz oder Empfehlung verlinkt wird. Auch die Glaubwürdigkeit der eigenen Inhalte kann durch die Verlinkung mit externen Inhaltsquellen erhöht werden.

Dabei gibt es zwei wichtige Arten von Links, die man im Rahmen der Suchmaschinenoptimierung kennen sollte:

- Interne Links

- Externe Links

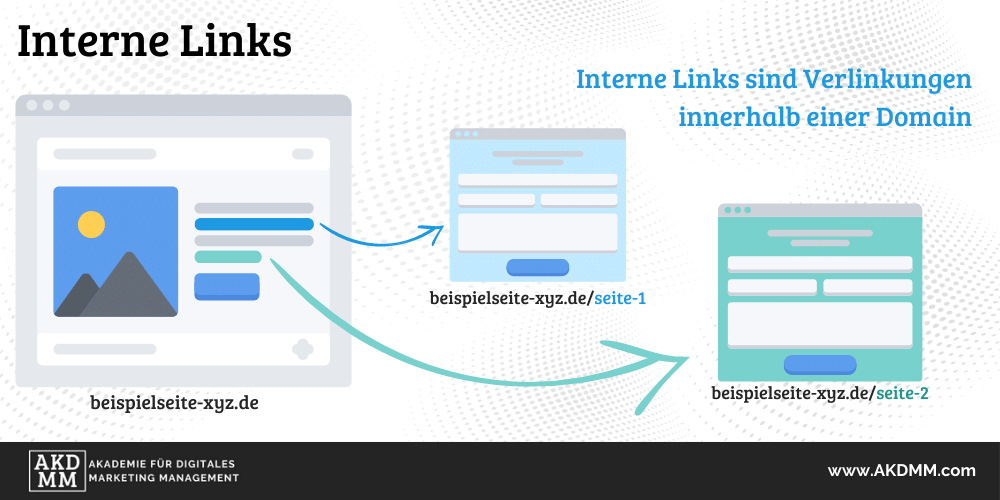

Nr. 28: Interne Links

Wenn Links innerhalb einer Domain gesetzt werden, spricht man von „internen Links“. Verweisen Links auf eine externe Quelle, also z.B. auf eine andere Website, spricht man von „externen Links“. Dies ist im Wesentlichen der Unterschied zwischen internen und externen Links.

Wenn also die Domain beispielseite-xyz.de innerhalb derselben Domain auf die Unterseite beispielseite-xyz.de/seite-1 verlinkt, handelt es sich um einen internen Link.

Abbildung: Veranschaulichung eines Beispiels für interne Links. // Quelle: AKDMM

Abbildung: Veranschaulichung eines Beispiels für interne Links. // Quelle: AKDMM

Die Bedeutung interner Links für die Benutzererfahrung.

Die interne Verlinkung ist ein wichtiges Kriterium, wenn es um die Optimierung der Nutzererfahrung innerhalb einer Website geht. Durch interne Links können sich Nutzer innerhalb einer Domain besser zurechtfinden. Vor allem wenn eine Website über eine hohe Website-Tiefe mit verschachtelten Inhalten verfügt, gewinnt die interne Verlinkung zunehmend an Bedeutung.

Interne Links erhöhen die thematische Relevanz einer Website.

Wenn eine bestimmte Seite einer Website ein Thema behandelt, zu dem es weitere, verwandte Themen gibt, können interne Links verwendet werden, um eine Verbindung zwischen den einzelnen Themen herzustellen. Dadurch erhöht sich die thematische Relevanz einer Website zu einem Themenkomplex. Eine Website mit hoher thematischer Relevanz kann vertrauensbildend auf die Nutzer wirken. Bei vielen qualitativ hochwertigen Inhalten können Nutzer den Eindruck gewinnen, dass sich die Website mit bestimmten Themen besonders gut auskennt.

Die Bedeutung interner Links aus Sicht der Suchmaschinen.

Suchmaschinen messen internen Links große Bedeutung bei. In Maßen eingesetzt, können sie sich positiv auf das Ranking einer Website auswirken. So wie sich Nutzer durch interne Links besser auf einer Website zurechtfinden, gilt dies auch für Crawler und Bots, die eine Website analysieren.

Wenn Crawler eine bestimmte Seite crawlen, werden sie durch interne Links auch auf andere Unterseiten einer Website aufmerksam. Wenn die verlinkten Inhalte dazu beitragen, die thematische Relevanz eines Themenkomplexes zu erhöhen, wirkt sich dies positiv auf die Gesamtbewertung aus. Bei Suchmaschinen kann dies im besten Fall zu einer Verbesserung der Position in den SERPs (Search Engine Result Pages) führen.

Nr. 29: Externe Links

Grundsätzlich gibt es zwei Arten von externen Links. Externe Links, die von einer anderen Website auf die eigene Website verweisen, und externe Links, die von der eigenen Website auf eine andere Website verweisen.

Diese beiden Arten von externen Links werden wie folgt bezeichnet:

- eingehende externe Links (Inbound-Links / Backlinks)

- ausgehende externe Links (Outbound Links)

Nr. 30: Backlinks

Links, die von anderen Websites auf die eigene Website verweisen, werden als eingehende externe Links bezeichnet. Eingehende externe Links werden auch „Backlinks“ oder „Inbound Links“ genannt.

Für die Suchmaschinenoptimierung (SEO) sind Backlinks wichtig. Sie dienen Suchmaschinen dazu, Aussagen über die Relevanz und Autorität einer Website zu treffen. In der Regel wird eine Website mit vielen qualitativ hochwertigen Backlinks als vertrauenswürdig und relevant eingestuft. Daher ist es wahrscheinlich, dass Websites mit einem guten Backlink-Profil höher in den Suchergebnissen gelistet werden.

Backlinks können als Empfehlungen angesehen werden.

Erhält eine Website einen Backlink, kann es sich um eine Empfehlung handeln. Wenn eine Website über qualitativ hochwertigen Inhalt mit hoher thematischer Relevanz verfügt, kann sie von anderen Websites als empfehlenswerte Quelle angesehen werden. Daher kann die Tatsache, dass Ihre eigene Website von anderen Quellen in Form eines Backlinks erwähnt wird, viel über die Qualität Ihres Inhalts aussagen.

Bedeutung von Backlinks für die Suchmaschinenoptimierung.

Für Suchmaschinen wie Google sind die eingehenden externen Links einer Website von besonderer Bedeutung. Dabei ist die Anzahl der Backlinks und vor allem die Qualität der Backlinkquellen ein wichtiges Rankingkriterium. Umso mehr Backlinks eine Website von vertrauenswürdigen Quellen erhält, desto positiver wirkt sich dies auf das Ranking aus. Kommen die Backlinks aus fragwürdigen oder unseriösen Quellen, wie z.B. massivem Backlinkkauf, kann sich dies negativ auf das Ranking auswirken.

Einsatz von SpamBrain bei Google.

Im Dezember 2022 wurde ein Update der Google-Suche veröffentlicht, das einen besonderen Fokus auf Backlinks und deren Qualität legte. Dieses sogenannte „Link Spam Update“ wurde mit Hilfe von „SpamBrain“ ausgerollt. Bei SpamBrain handelt es sich um ein auf KI (Künstliche Intelligenz) basierendes System zur Verhinderung von Backlink-Spam. Nach Angaben von Google erkennt SpamBrain Websites, die gekaufte Links verwenden. Mit dem Update verfolgt Google das Ziel, die künstliche Manipulation von Suchergebnissen durch Link-Spam zu verhindern. Quelle: (Google.com, 2022)

Nr. 31: Outbound-Links

Ausgehende externe Links sind Links auf der eigenen Website, die auf andere Websites verweisen. Diese werden auch als „Outbound-Links“ („outbound“ = deutsch: „ausgehend“) bezeichnet.

Relevanz ausgehender Links für die Suchmaschinenoptimierung.

Einer der wichtigsten Aspekte für Suchmaschinen zum Aufbau eines Informationsnetzwerkes ist die Verlinkung von Websites. Dies betrifft sowohl Backlinks als auch Outbound-Links. Ein Outbound-Link, der auf eine andere Website verweist, kann Suchmaschinen bei der Suche nach weiteren relevanten Inhalten zu einem Thema aus anderen Quellen helfen. Erweisen sich die verlinkten Websites und deren Inhalte als gute Referenzen, kann sich dies auch positiv auf die Websites auswirken, die den Link gesetzt haben.

Nr. 32: Broken Links (404-Fehler)

Kann eine bestimmte Seite innerhalb einer Website nicht gefunden werden, liegt dies nicht selten an einem 404-Fehler. In diesem Fall zeigt der Browser eine Meldung an, dass die gesuchte Seite nicht gefunden wurde.

Bei 404-Fehlern handelt es sich um HTTP-Statuscodes.

Der HTTP-Statuscode 404 zeigt an, dass eine angeforderte Seite nicht gefunden werden konnte. In einem solchen Fall versucht der Browser, eine bestimmte Seite aufzurufen, die z.B. als interner Link innerhalb einer Website verlinkt ist. Kann die Seite nicht aufgerufen werden, erscheint der 404-Fehler.

Statuscodes geben den aktuellen Status einer aufgerufenen Seite an. Neben dem 404-Fehler gibt es noch weitere Statuscodes. Der Statuscode 200 zeigt beispielsweise an, dass eine Seite erfolgreich aufgerufen werden konnte. Man spricht in diesem Fall auch von einem Broken Link (deutsch: "kaputter oder defekter Link").

Die Bedeutung des 404-Fehlers für die Suchmaschinenoptimierung.

Für den Nutzer können 404-Fehler ein Ärgernis sein, wenn die erwartete Seite nicht angezeigt wird. Aus Sicht der Suchmaschinen werden 404-Fehler zum Problem, wenn sie gehäuft auftreten. Broken Links, bei denen die verlinkten Seiten nicht mehr existieren, wirken sich negativ auf interne Verlinkungsprozesse aus. Durch Abbrüche aufgrund nicht auffindbarer Seiten werden Suchmaschinen am reibungslosen Crawling gehindert.

Autor dieses Beitrags:

![]()

Christos Farakos ist seit über 15 Jahren im digitalen Marketing führender Unternehmen tätig. In seinen letzten beruflichen Stationen war er als "Head of Marketing DACH" eines Geschäftsbereichs eines internationalen Konzerns und als "Leiter Marketing" im öffentlichen Dienst tätig. Davor arbeitete er viele Jahre in den Bereichen SEO, SEA und Performance Marketing für ein international agierendes und weltweit führendes Unternehmen sowie für eine Digital Marketing Agentur eines der größten Agenturnetzwerke der Welt.